GPT4All 接入 RealmRouter LLM API

使用AI协作家能够有效提升工作效率,但在处理敏感信息时,我们只信任本地部署的模型,以防止信息泄露。通过综合构建本地知识库,我们可以减少对云端AI的依赖,同时确保回答的准确性和专业性,使其成为企业专属的"私人智库"。

我们通过本文档介绍如何使用GPT4All接入RealmRouter云帆提供的高性能大模型API,构建专属本地知识库,让AI成为您企业的"私人助手"。

RealmRouter × GPT4All 配置教程

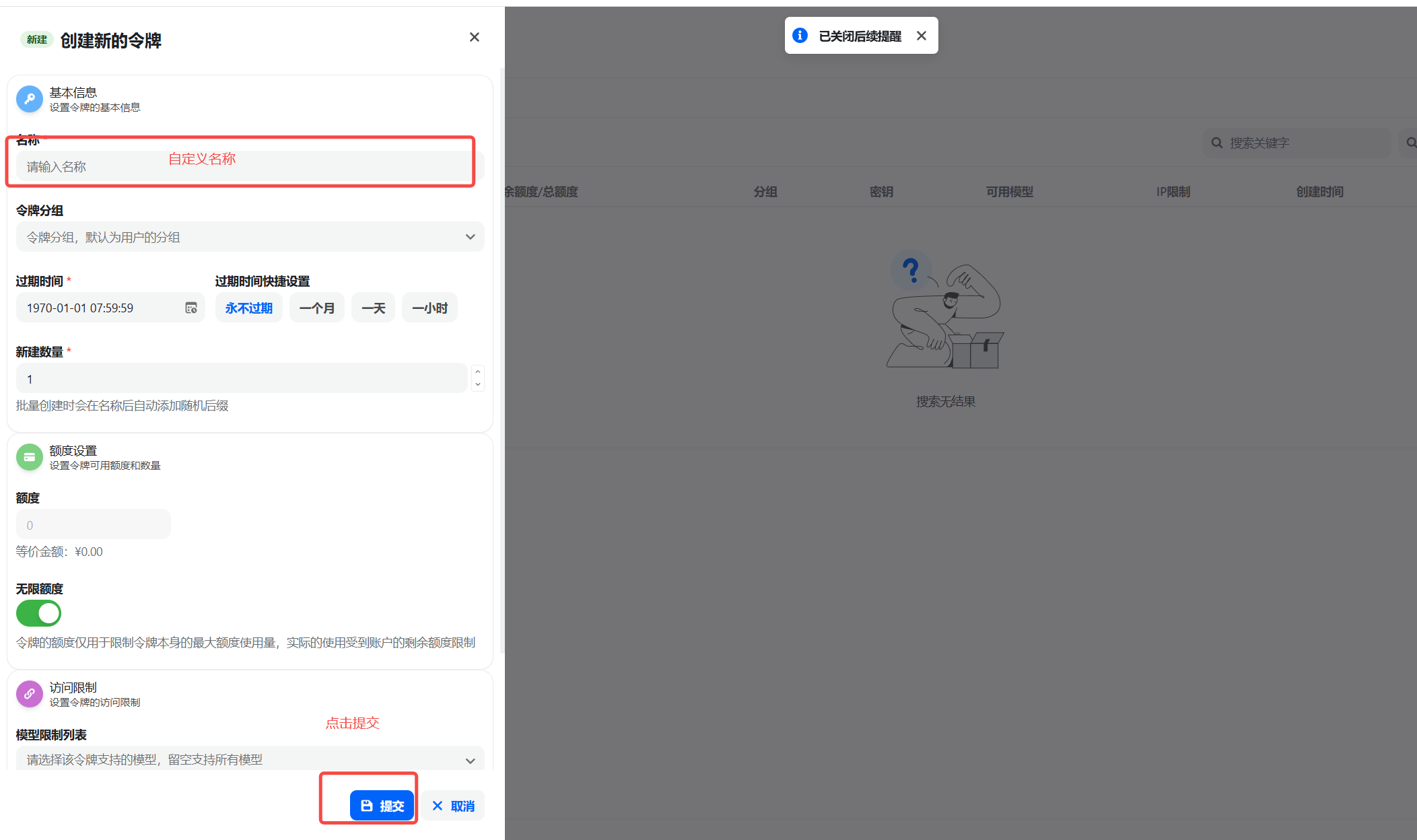

第一步:获取 API key

- 获取 API 密钥

注册登录云帆平台,填写邀请码:7UAT,即可获得 10元余额。

在 API 密钥管理页面,点击"创建密钥"按钮,自定义密钥名称,即可生成API密钥。

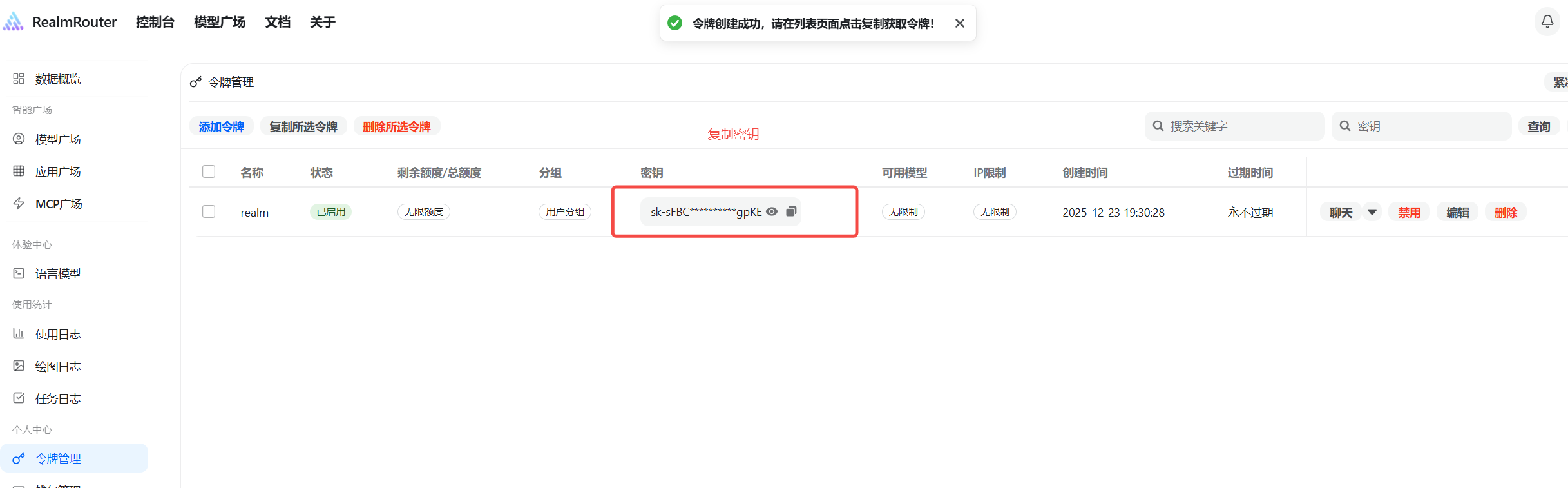

- 保存并复制 API 密钥

!!注意: 密钥在服务器未加密存储,请妥善保管密钥,避免泄露。如密钥泄露,可在控制台删除后重新创建一个新的密钥。

- 获取(模型ID)

需要用到的模型ID

- deepseek/deepseek-r1-turbo

- deepseek/deepseek-v3-0324

- qwen/qwen3-235b-a22b-fp8

- qwen/qwen3-30b-a3b-fp8

这些模型ID的具体价格和配置可参考模型列表

第二步:下载并配置GPT4All

- 下载GPT4All

访问GPT4All官方网站下载对应应用程序。

下载地址:https://www.nomic.ai/gpt4all

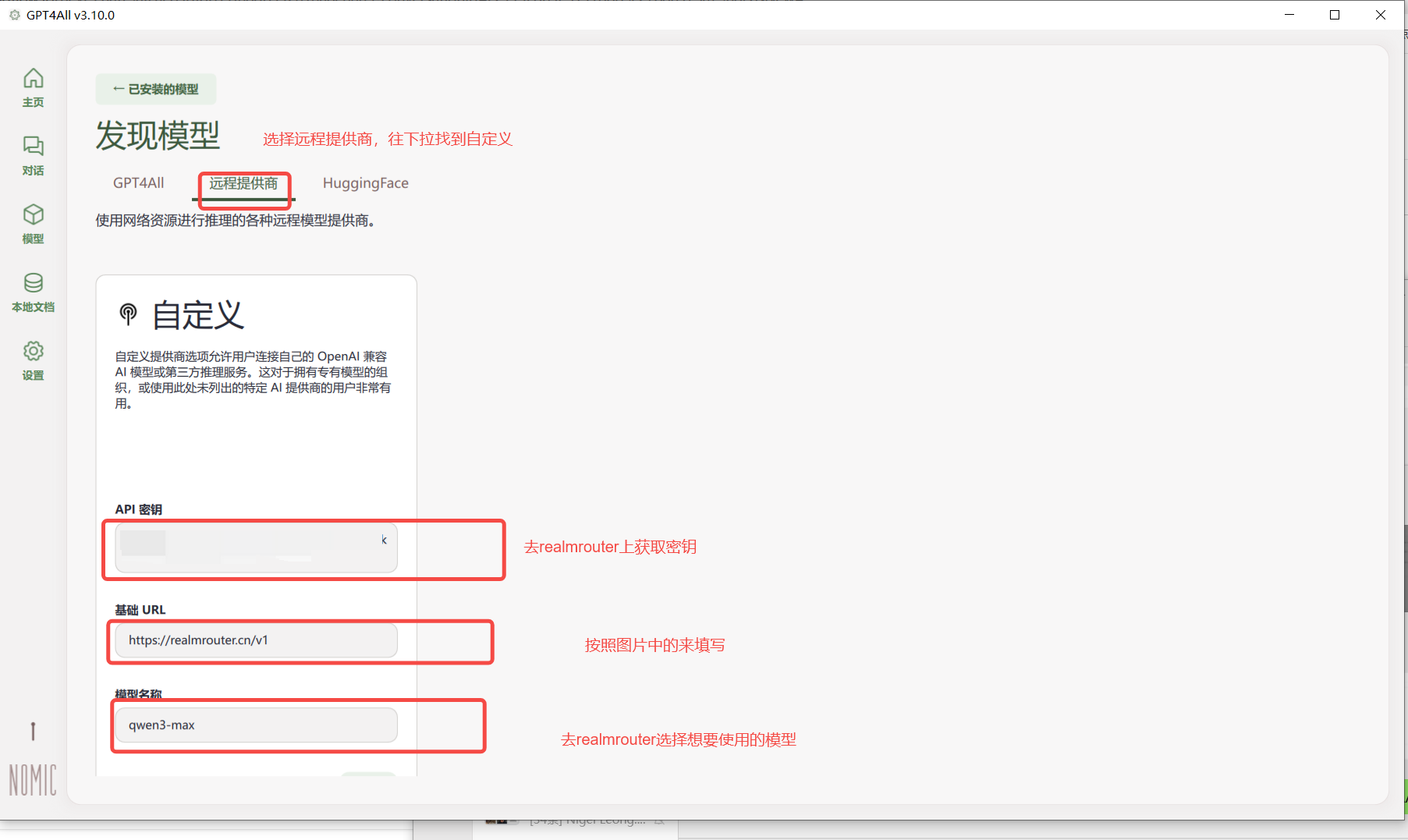

- 配置API密钥

在页面中,点击"模型"->"自定义"->"应用数据"。

在 API密钥处填入云帆平台获取的API密钥。

在 基础URL处填入:https://realmrouter.cn

在 模型名称处填入需要使用的模型名称,例如:deepseek/deepseek-v3-0324

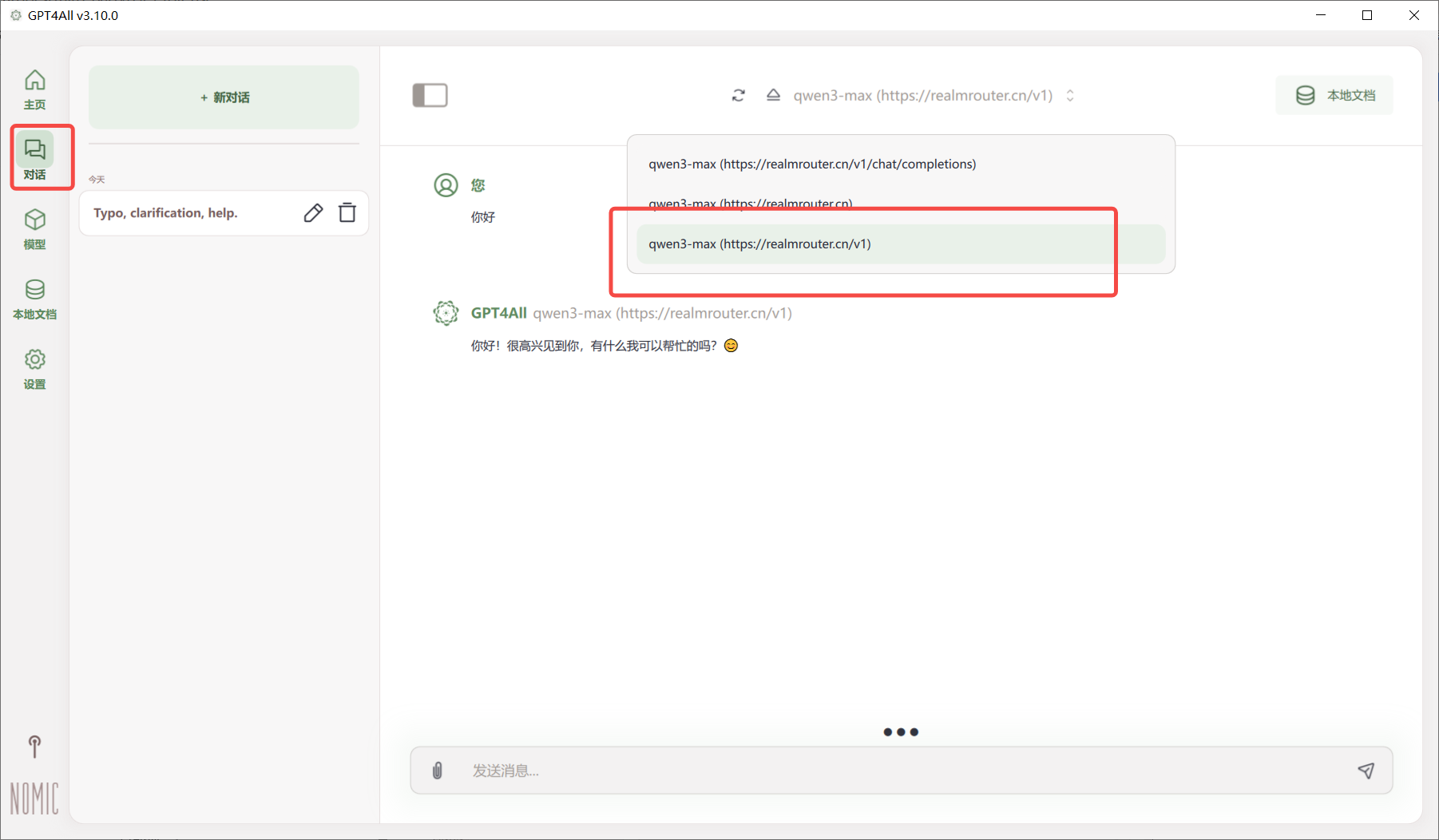

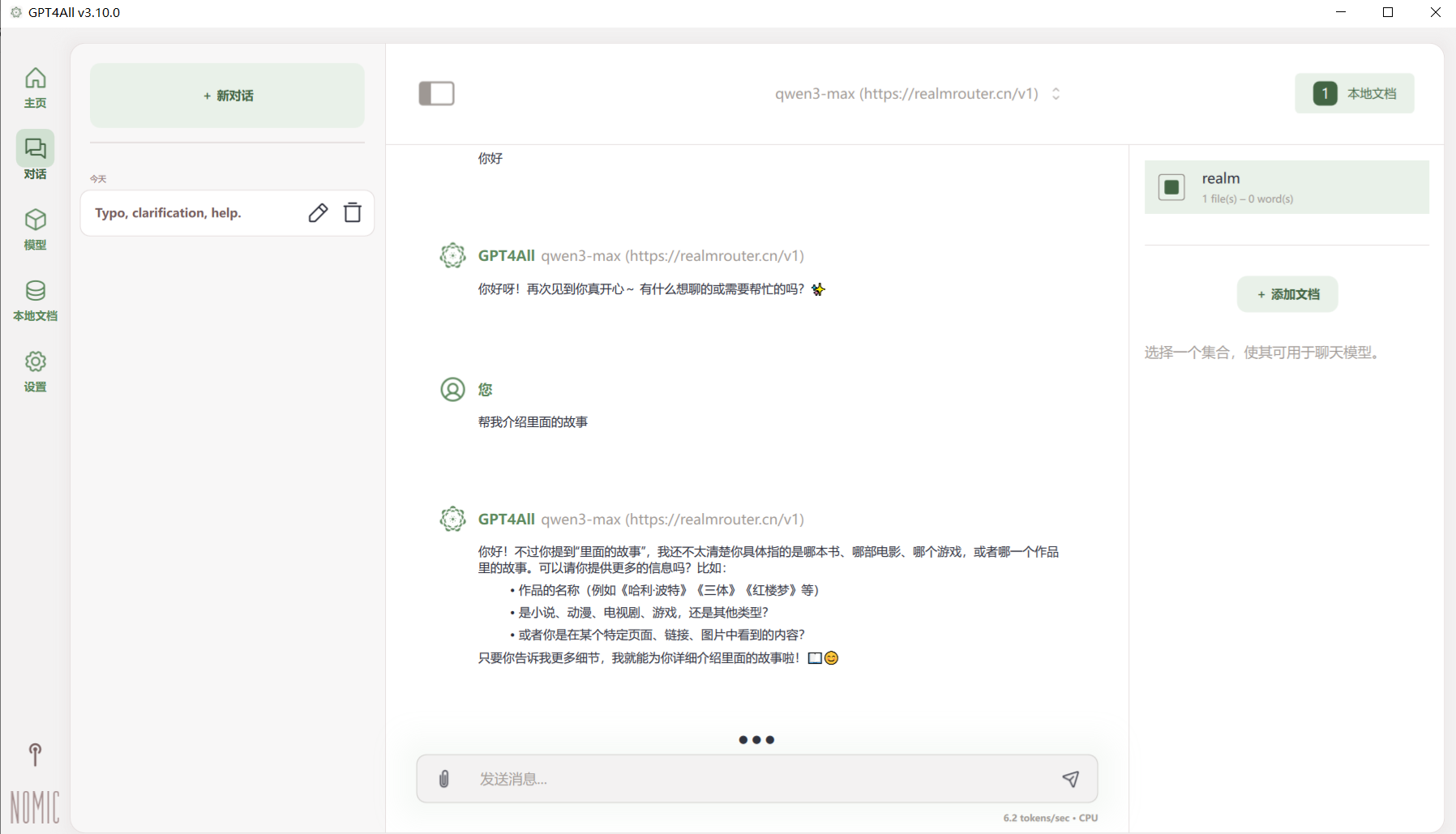

- 选择对话模型

打开对话窗口,选择需要使用的模型,此时已经可以开始进行对话,但为了构建私有知识库,我们需要进行下一步配置。

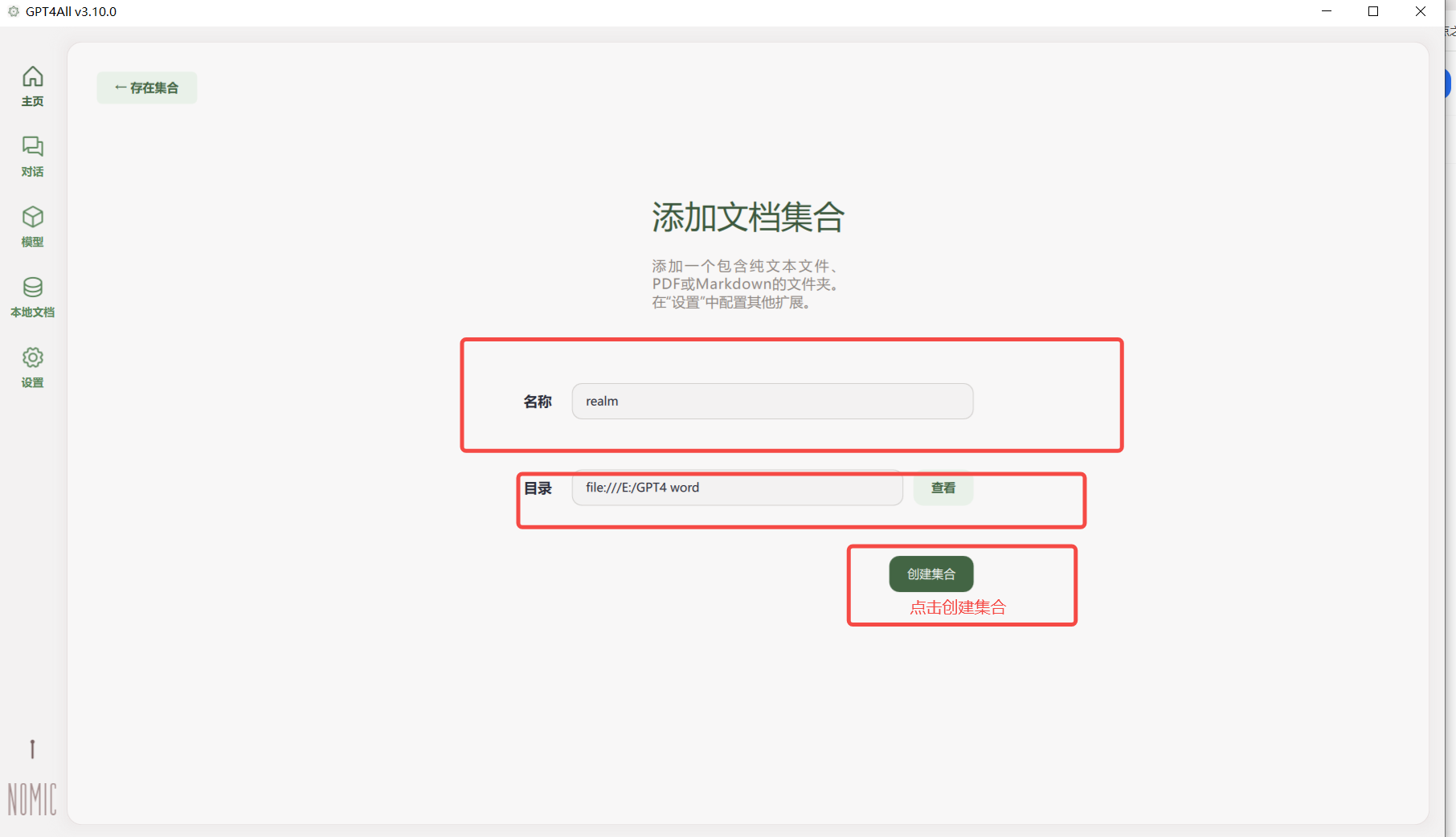

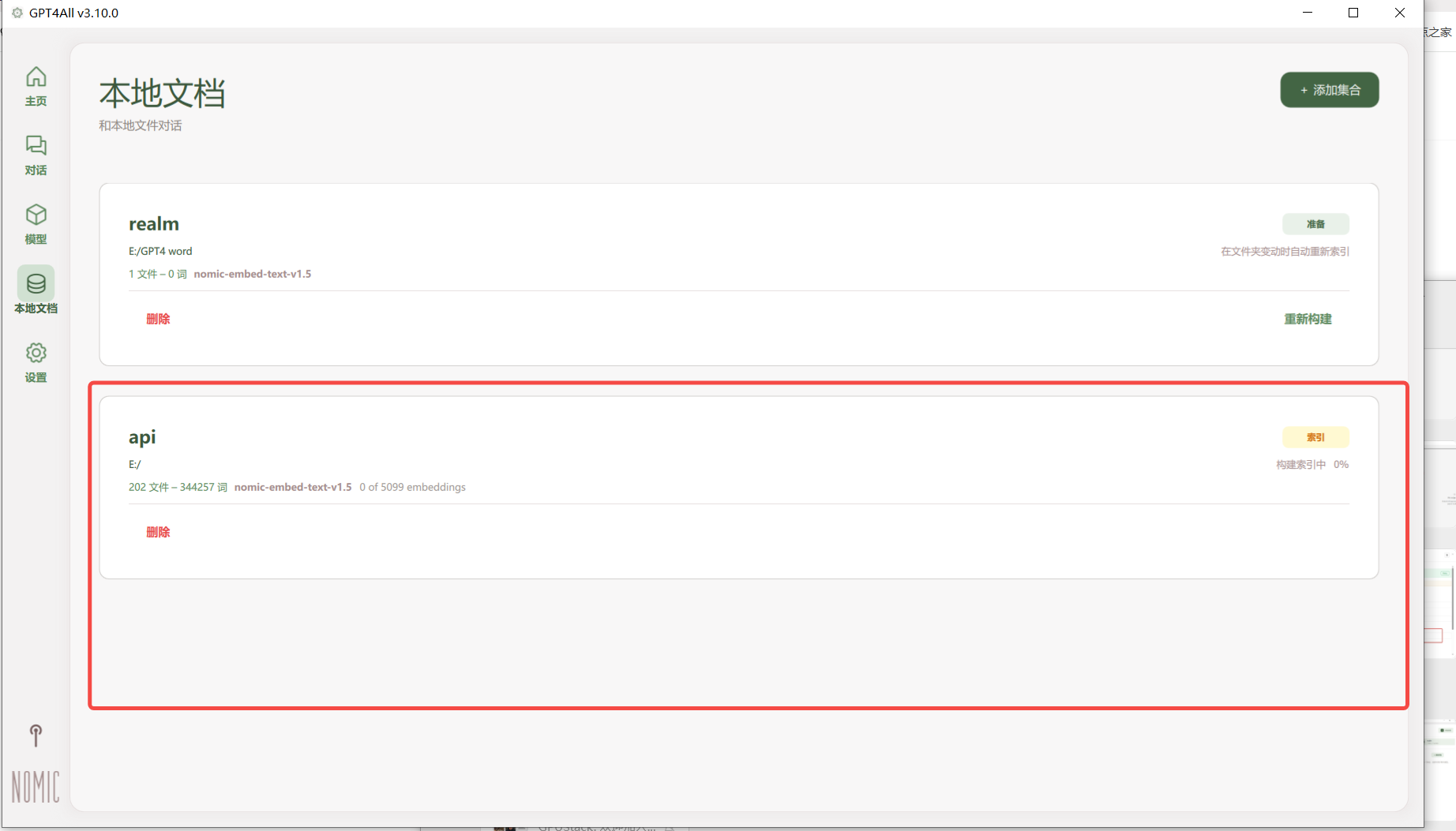

第三步:构建私有知识库

- 上传文档资料

在知识库管理中,选择需要上传的文档资料,支持多种文档格式,包括PDF、Word、TXT等。

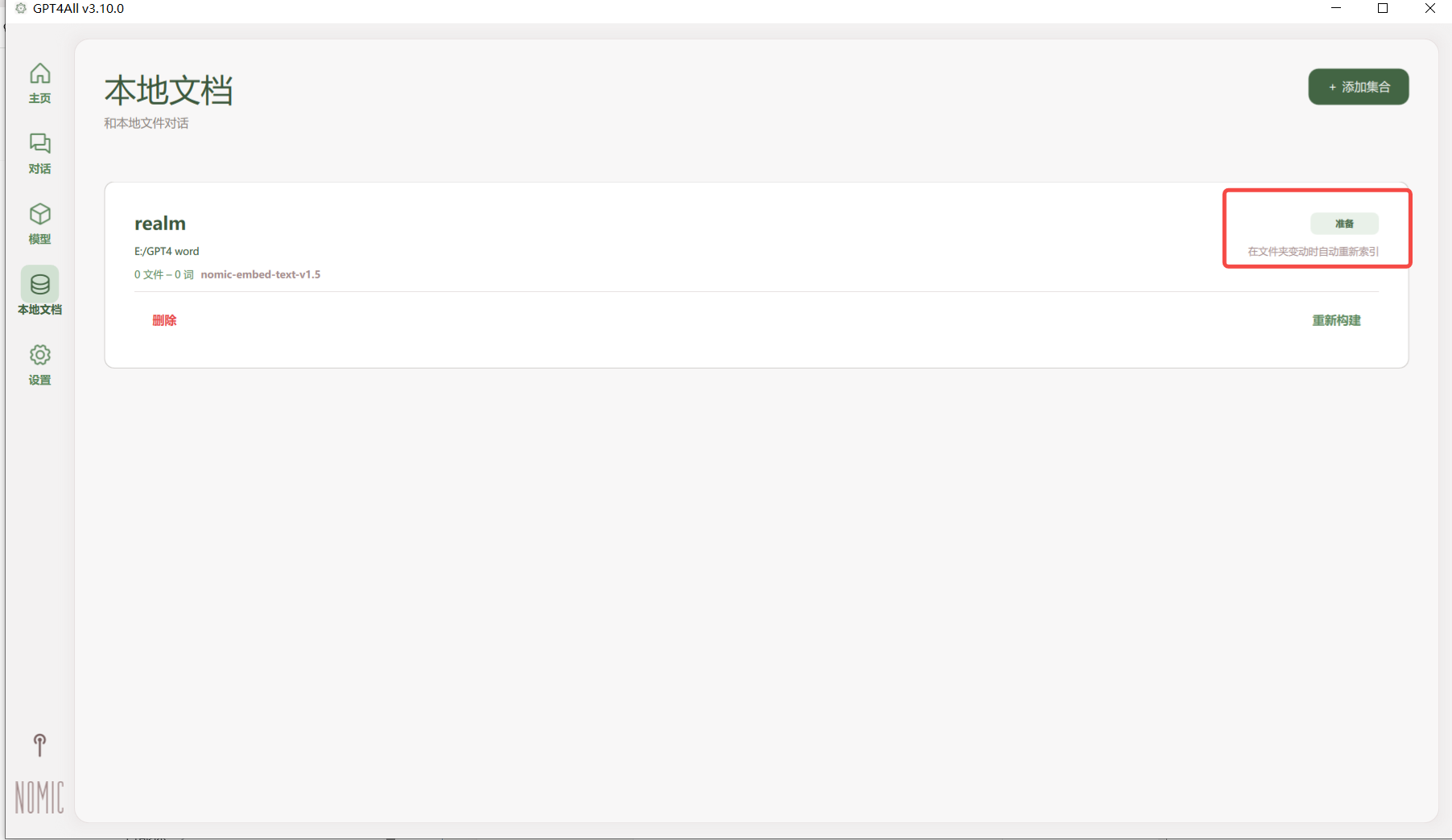

- 选择Embedding模型

文档上传后,系统会自动选择合适的Embedding模型,模型会根据文档内容进行向量化处理,便于后续检索使用。

- 使用私有知识库

返回对话页面,选择当前对话使用的知识库,此时对话时就可以看到模型从本地知识库开始检索,并生成回答。

总结

通过以上步骤,您已经成功将GPT4All接入RealmRouter云帆的大模型API,并构建了专属的私有知识库。这种方案既保证了数据的安全性,又能够利用高性能的大模型提供准确的回答,是企业构建AI知识库的理想选择。

优势

- 数据安全:所有敏感信息都在本地处理,不会泄露到外部

- 高性能模型:使用RealmRouter云帆提供的高性能大模型,确保回答质量

- 成本效益:按需付费,无需投入大量硬件资源

- 易于使用:简单的配置过程,无需专业技术背景

常见问题

Q: 如何更换使用的模型?

A: 在GPT4All的模型设置中,修改"模型名称"字段为您想要使用的其他模型ID即可。

Q: 支持哪些文档格式?

A: GPT4All支持多种文档格式,包括PDF、Word、TXT、Markdown等常见格式。

Q: 如何管理多个知识库?

A: 在知识库管理界面,可以创建多个不同的知识库,并在对话时选择使用哪个知识库。

Q: API密钥的安全性如何保障?

A: 请妥善保管您的API密钥,不要在代码中硬编码,建议使用环境变量或配置文件存储。如怀疑密钥泄露,请及时在控制台重新生成。

.PNG?fit=max&auto=format&n=oBzzq-U4N4SIxMnr&q=85&s=f4ddfeda7650665d08bedc7533d362f7)